Die Arbeit mit Daten kann komplex sein und oft ist die "richtige" Antwort für den jeweiligen Zweck das Ergebnis einer Reihe von Iterationen, bei denen Fachexperten (KMU) und Datenexperten zusammenarbeiten.

Dies ist von Natur aus ein iterativer Prozess. Selbst bei bestem Engagement und verfügbarem Wissen unterliegt das resultierende Datenmodell dem zunehmenden Verständnis, das mit der Arbeit mit Daten einhergeht.

Mit anderen Worten: Das Data Solution Modell ist nicht immer etwas, das man auf Anhieb richtig machen kann. In der Realität kann es lange dauern, bis sich ein Modell festigt, und in den heutigen schnelllebigen Umgebungen kann dies sogar nie eintreten.

Die Wahl der richtigen Design Patterns für Ihre Data Solution trägt dazu bei, dass sich die Lösung mit dem Unternehmen und der Technologie weiterentwickelt und die technischen Schulden laufend reduziert werden.

Diese Einstellung ermöglicht auch einige faszinierende Möglichkeiten, wie z. B. die Versionskontrolle des Datenmodells, der Design-Metadaten und ihrer Beziehungen - um die gesamte Datenlösung so darzustellen, wie sie zu einem bestimmten Zeitpunkt war - oder um verschiedene Datenmodelle für verschiedene Geschäftsbereiche zu ermöglichen.

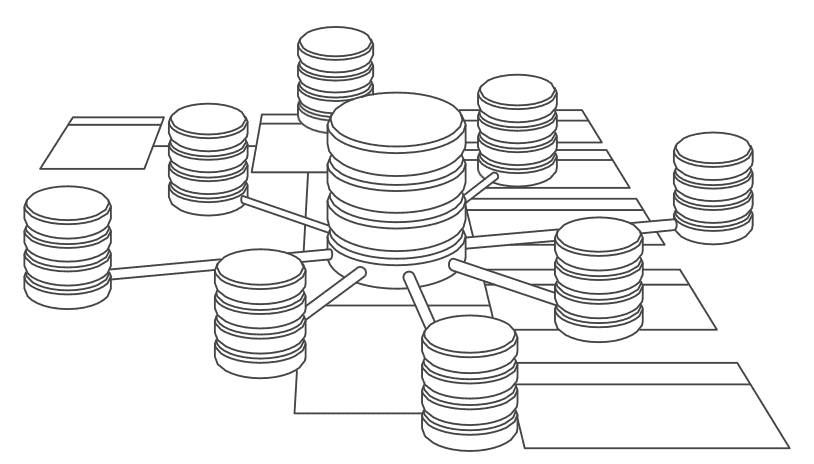

Diese Idee, kombiniert mit der Möglichkeit, automatisch verschiedene Strukturen und Interpretationen von Daten sowie die Datenlogistik zu deren Befüllung oder Übermittlung bereitzustellen, nennen wir "Data Solution Virtualisierung".

Die Idee einer automatisierten virtuellen Data Solution entstand bei der Arbeit an der Verbesserung der Generierung von Data Warehouse Ladeprozessen. Es handelt sich gewissermaßen um eine Weiterentwicklung der ETL-Generierung. Die Kombination von Data Vault mit einer Persistent Staging Area (PSA) bietet zusätzliche Funktionalität, da sie es dem Entwickler ermöglicht, die gesamte Lösung oder Teile davon neu zu erstellen.

Die Möglichkeit, eine virtuelle Data Solution bereitzustellen, bietet mehrere Optionen. Das bedeutet nicht, dass Sie die gesamte Lösung virtualisieren müssen, aber Sie können auswählen, welcher Ansatz für das jeweilige Szenario am besten geeignet ist und Technologien und Modelle im Laufe der Zeit ändern.

Coaching

Coaching  Inhouse

Inhouse